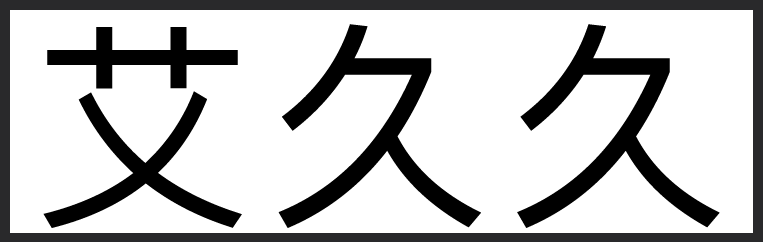

Daniel Jeffries 这个对...

- 歸藏的AI工具箱

- 2025-01-23 19:47:56

Daniel Jeffries 这个对 Deepseek R1 论文的总结很详细:AI创造营ai

RL并非万能:DeepSeek-R1 结合了两次强化学习(RL)和两次监督微调(SFT),而非仅依赖RL。

GRPO的优势:作为PPO的改进版本,GRPO显著降低了内存和计算需求,且无需“评论家模型”(Critic Model),建议所有实验室尝试。

推理能力的局限性:当前模型在数学、编程等可验证任务上表现优异,但难以泛化到模糊推理任务(如广告设计优劣判断)。

合成数据的关键性:OpenAI/Anthropic/Google等巨头通过自有顶尖模型生成合成数据以训练更优模型,而普通开发者受限于服务条款无法效仿。

蒸馏模型的真相:Qwen和Llama的蒸馏模型仅通过SFT训练,未使用RL。

核心开放问题:“硬推理能力提升能否增强模糊推理能力?” 目前尚无定论,但这是全球AI实验室的焦点研究方向。

来源:x.com/Dan_Jeffries1/status/1881679981849215080

RL并非万能:DeepSeek-R1 结合了两次强化学习(RL)和两次监督微调(SFT),而非仅依赖RL。

GRPO的优势:作为PPO的改进版本,GRPO显著降低了内存和计算需求,且无需“评论家模型”(Critic Model),建议所有实验室尝试。

推理能力的局限性:当前模型在数学、编程等可验证任务上表现优异,但难以泛化到模糊推理任务(如广告设计优劣判断)。

合成数据的关键性:OpenAI/Anthropic/Google等巨头通过自有顶尖模型生成合成数据以训练更优模型,而普通开发者受限于服务条款无法效仿。

蒸馏模型的真相:Qwen和Llama的蒸馏模型仅通过SFT训练,未使用RL。

核心开放问题:“硬推理能力提升能否增强模糊推理能力?” 目前尚无定论,但这是全球AI实验室的焦点研究方向。

来源:x.com/Dan_Jeffries1/status/1881679981849215080