记忆层在LLMs中存储facts时使用的...

- 西晋无畏的鱼丸

- 2025-01-13 21:33:06

记忆层在LLMs中存储facts时使用的计算量比传统密集层少10倍。

因此,这些记忆增强的LLMs在计算量减少90%的情况下实现了与更大模型相同的准确性。

记忆层为LLMs添加了可训练的键值查找,能够在不增加计算成本的情况下增加参数,显著提高了事实准确性。

原始问题:

LLMs需要大量计算来存储和回忆简单的事实,如生日或首都城市。当前的密集神经网络对于这种基本信息存储效率低下。

本文中的解决方案:

→ 记忆层使用可训练的键值查找来增加额外参数而不增加FLOPs

→ 系统实现了产品键查找,使用两组键进行高效检索

→ 记忆参数在多个层之间共享,同时保持参数数量不变

→ 自定义CUDA内核实现了3 TB/s的内存带宽,而PyTorch中为400 GB/s

→ 优化的反向传递使用无原子的方法以获得更好的梯度计算

关键见解:

→ 记忆层补充了密集前馈层,以更低成本存储信息

→ 成功扩展到128B记忆参数,训练于1T个token

→ 对于事实问答、编码和知识任务特别有效

→ 提供了在不需要大量计算的情况下扩展AI的路径

结果:

→ 模型在使用2倍计算预算的情况下优于密集版本

→ 在问答基准测试中事实准确性提高100%

→ 在64M键时,1.3B记忆模型与使用10倍FLOPs训练的Llama2 7B相匹配

→ 记忆增强的8B模型等同于在15倍token上训练的模型

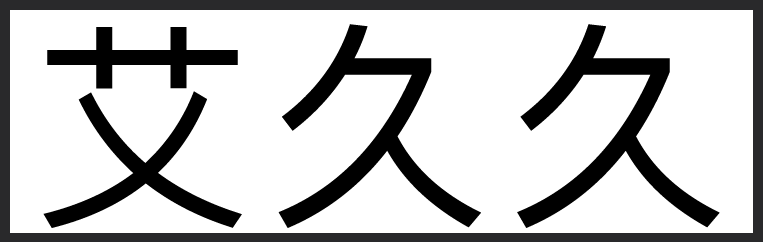

论文标题:“大规模记忆层” AI创造营

因此,这些记忆增强的LLMs在计算量减少90%的情况下实现了与更大模型相同的准确性。

记忆层为LLMs添加了可训练的键值查找,能够在不增加计算成本的情况下增加参数,显著提高了事实准确性。

原始问题:

LLMs需要大量计算来存储和回忆简单的事实,如生日或首都城市。当前的密集神经网络对于这种基本信息存储效率低下。

本文中的解决方案:

→ 记忆层使用可训练的键值查找来增加额外参数而不增加FLOPs

→ 系统实现了产品键查找,使用两组键进行高效检索

→ 记忆参数在多个层之间共享,同时保持参数数量不变

→ 自定义CUDA内核实现了3 TB/s的内存带宽,而PyTorch中为400 GB/s

→ 优化的反向传递使用无原子的方法以获得更好的梯度计算

关键见解:

→ 记忆层补充了密集前馈层,以更低成本存储信息

→ 成功扩展到128B记忆参数,训练于1T个token

→ 对于事实问答、编码和知识任务特别有效

→ 提供了在不需要大量计算的情况下扩展AI的路径

结果:

→ 模型在使用2倍计算预算的情况下优于密集版本

→ 在问答基准测试中事实准确性提高100%

→ 在64M键时,1.3B记忆模型与使用10倍FLOPs训练的Llama2 7B相匹配

→ 记忆增强的8B模型等同于在15倍token上训练的模型

论文标题:“大规模记忆层” AI创造营