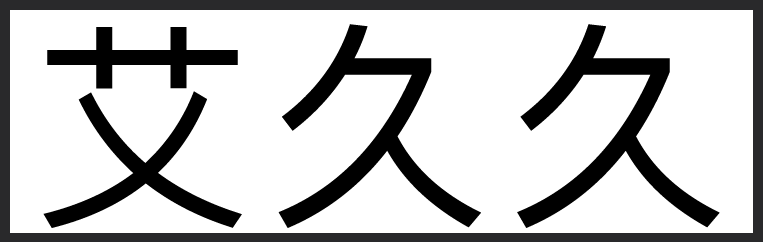

LoRA技术

- HuggingFace

- 2024-11-30 07:47:42

重磅发布:GGUF-my-LoRA,让 LoRA 转换更简单!

LoRA(Low-Rank Adaptation)是一种高效微调大语言模型的技术,让你可以快速为模型添加新技能!比如,将一个通用聊天机器人改造成客服助手、法律顾问或医疗专家,轻松实现高效适配。

通过 GGUF-my-LoRA,你可以将 Hugging Face 的 PEFT LoRA 适配器轻松转换为 GGUF 格式,并与 GGUF 基础模型无缝结合!

如何操作?

登录 Hugging Face,打开 GGUF-my-LoRA 空间。

选择你的 PEFT LoRA 适配器进行转换。

转换完成后,你将获得一个全新的 GGUF LoRA 适配器,随时可以加载到模型中!

支持方式:

通过 llama-cli: 加载基础模型并添加 LoRA,支持自定义缩放比例!

通过 llama-server: 一次加载多个 LoRA 适配器,还能动态热重载,适配更灵活!

想让你的模型更强大、更专业?现在就去体验 GGUF-my-LoRA,解锁无限可能!

欢迎加入我们的中文社区:Chinese LLMs on Hugging Face,一起探索更多生成式 AI 的奥秘!

#AI创造营#LoRA技术HuggingFace

LoRA(Low-Rank Adaptation)是一种高效微调大语言模型的技术,让你可以快速为模型添加新技能!比如,将一个通用聊天机器人改造成客服助手、法律顾问或医疗专家,轻松实现高效适配。

通过 GGUF-my-LoRA,你可以将 Hugging Face 的 PEFT LoRA 适配器轻松转换为 GGUF 格式,并与 GGUF 基础模型无缝结合!

如何操作?

登录 Hugging Face,打开 GGUF-my-LoRA 空间。

选择你的 PEFT LoRA 适配器进行转换。

转换完成后,你将获得一个全新的 GGUF LoRA 适配器,随时可以加载到模型中!

支持方式:

通过 llama-cli: 加载基础模型并添加 LoRA,支持自定义缩放比例!

通过 llama-server: 一次加载多个 LoRA 适配器,还能动态热重载,适配更灵活!

想让你的模型更强大、更专业?现在就去体验 GGUF-my-LoRA,解锁无限可能!

欢迎加入我们的中文社区:Chinese LLMs on Hugging Face,一起探索更多生成式 AI 的奥秘!

#AI创造营#LoRA技术HuggingFace