本地 LLM 重大更新!很高兴与您分享...

- 斌叔OKmath

- 2024-10-22 17:11:05

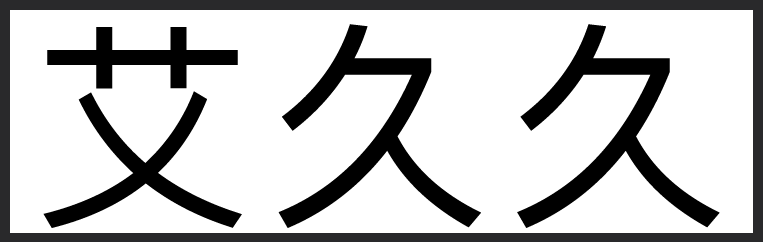

本地 LLM 重大更新!很高兴与您分享,您现在可以轻松地将

@huggingface

上的任何 GGUF 模型直接与

@ollama

一起使用!只需指向 Hugging Face 存储库并运行它!以下是如何运行

@AIatMeta

Llama 3.2 3B!

1. 在集线器上找到您的 GGUF 重量,例如 Llama 3.2 3B

2. `ollama run hf (.) co/hugging-quants/Llama-3.2-3B-Instruct-Q4_K_M-GGUF` 删除()

3. 使用 llama.cpp 的功能在本地与你的模型聊天

@huggingface

上的任何 GGUF 模型直接与

@ollama

一起使用!只需指向 Hugging Face 存储库并运行它!以下是如何运行

@AIatMeta

Llama 3.2 3B!

1. 在集线器上找到您的 GGUF 重量,例如 Llama 3.2 3B

2. `ollama run hf (.) co/hugging-quants/Llama-3.2-3B-Instruct-Q4_K_M-GGUF` 删除()

3. 使用 llama.cpp 的功能在本地与你的模型聊天