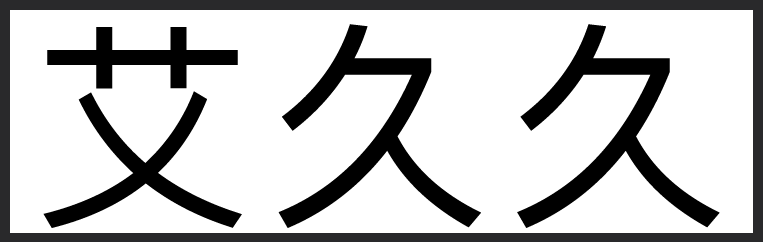

500xCompressor: Generalized...

- AMiner学术头条

- 2024-08-11 01:40:14

500xCompressor: Generalized Prompt Compression for Large Language Models 网页链接

网页链接

这篇论文介绍了一种名为500xCompressor的方法,旨在压缩大型语言模型(LLM)的输入提示,以提高推理速度、降低成本和改善用户体验。现有方法面临的问题包括压缩比低和评估过程中可能的数据泄露。500xCompressor能将大量的自然语言上下文压缩成一个或多个特殊的令牌,引入约0.3%的额外参数,实现6倍至480倍的压缩比。该方法适用于压缩任何文本,回答各种类型的问题,并且不需要对原始的LLM进行微调即可使用。研究首先在Arxiv语料库上预训练500xCompressor,然后在ArxivQA数据集上微调,并在未见过的严格问题和经典问答(QA)数据集上进行评估。结果显示,与使用非压缩提示相比,LLM保持了62.26-72.89%的能力。研究还表明,并非所有压缩的令牌都被同等利用,K V值在高压缩比下比嵌入更能保留信息。即使对于细粒度的复杂信息,自然语言提示的高度压缩性质也表明了未来应用和进一步研究开发新型LLM语言的潜力。

人工智能

人工智能 博士

博士 大模型

大模型 论文写作

论文写作

网页链接

网页链接这篇论文介绍了一种名为500xCompressor的方法,旨在压缩大型语言模型(LLM)的输入提示,以提高推理速度、降低成本和改善用户体验。现有方法面临的问题包括压缩比低和评估过程中可能的数据泄露。500xCompressor能将大量的自然语言上下文压缩成一个或多个特殊的令牌,引入约0.3%的额外参数,实现6倍至480倍的压缩比。该方法适用于压缩任何文本,回答各种类型的问题,并且不需要对原始的LLM进行微调即可使用。研究首先在Arxiv语料库上预训练500xCompressor,然后在ArxivQA数据集上微调,并在未见过的严格问题和经典问答(QA)数据集上进行评估。结果显示,与使用非压缩提示相比,LLM保持了62.26-72.89%的能力。研究还表明,并非所有压缩的令牌都被同等利用,K V值在高压缩比下比嵌入更能保留信息。即使对于细粒度的复杂信息,自然语言提示的高度压缩性质也表明了未来应用和进一步研究开发新型LLM语言的潜力。

人工智能

人工智能 博士

博士 大模型

大模型 论文写作

论文写作