LLM内部关联能力像人脑

- 量子位

- 2025-01-12 05:10:54

LLM内部关联能力像人脑

LLM的“思考”方式不一定是线性的,可能会像人类大脑一样,具备多维关联能力。

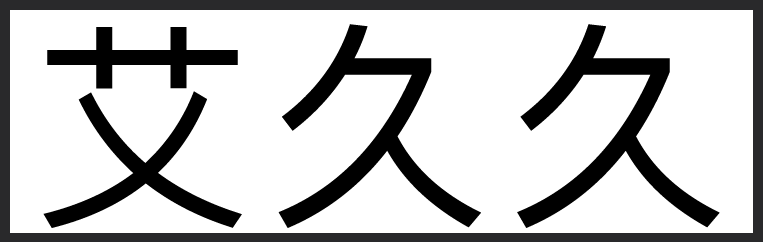

最近,哈佛大学多名物理系专家做了个实验,他们把一大堆词,如苹果、鸟、牛奶,排列在一个网格中,并按照随机顺序输出【图1】,并让Llama-3.1-8B学习。

结果发现,模型出现了一种非常节省能量的方式:它在多维数据中,仅用了几个主成分(principal components),便最大程度保留了原本复杂的信息。

这种能力人类同样具备,研究人员让人观看随机序列的图像,同时进行 fMRI 脑扫描,最终大脑能够从脑成像数据中重建出图形(graph)结构【图2】。

举个通俗的例子,假设有这样一组城市多维数据,包含两地之间的开车时间、步行时间、坐公交的时间等。

如果我们把这些时间都记住,就太复杂了。

而要是只记住两地之间的距离,再根据不同出行方式的速度换算时间,就好记得多。

话说回来,为了确保实验严谨,研究人员还用环形图替换了网状图,结果同样发现了LLM内部的知识重组现象【图3】。

知识重组、关联只是一种口语化表达,他们在论文中把该现象称为“In-Context Representations”(上下文表达),具体效果长这样——【图4】。

那么,LLM出现的这种现象,又和能量有什么关系?

研究人员分析了模型的狄利克雷能量(Dirichlet energy)【图5】后发现,随着上下文增多,模型表示的谱能量(spectral energy)居然在降低。

当能量降到某个临界点后,模型记住规则的准确率也会显著提升【图6】!

这就有点像,LLM在用一种更省能量的方式,在理解、记忆这个世界。

感兴趣的小伙伴可以阅读原文: 网页链接

网页链接

LLM的“思考”方式不一定是线性的,可能会像人类大脑一样,具备多维关联能力。

最近,哈佛大学多名物理系专家做了个实验,他们把一大堆词,如苹果、鸟、牛奶,排列在一个网格中,并按照随机顺序输出【图1】,并让Llama-3.1-8B学习。

结果发现,模型出现了一种非常节省能量的方式:它在多维数据中,仅用了几个主成分(principal components),便最大程度保留了原本复杂的信息。

这种能力人类同样具备,研究人员让人观看随机序列的图像,同时进行 fMRI 脑扫描,最终大脑能够从脑成像数据中重建出图形(graph)结构【图2】。

举个通俗的例子,假设有这样一组城市多维数据,包含两地之间的开车时间、步行时间、坐公交的时间等。

如果我们把这些时间都记住,就太复杂了。

而要是只记住两地之间的距离,再根据不同出行方式的速度换算时间,就好记得多。

话说回来,为了确保实验严谨,研究人员还用环形图替换了网状图,结果同样发现了LLM内部的知识重组现象【图3】。

知识重组、关联只是一种口语化表达,他们在论文中把该现象称为“In-Context Representations”(上下文表达),具体效果长这样——【图4】。

那么,LLM出现的这种现象,又和能量有什么关系?

研究人员分析了模型的狄利克雷能量(Dirichlet energy)【图5】后发现,随着上下文增多,模型表示的谱能量(spectral energy)居然在降低。

当能量降到某个临界点后,模型记住规则的准确率也会显著提升【图6】!

这就有点像,LLM在用一种更省能量的方式,在理解、记忆这个世界。

感兴趣的小伙伴可以阅读原文:

网页链接

网页链接